»SEC-Learn« ist ein Projekt von elf Fraunhofer-Instituten, das einen großen Technologiesprung im Bereich der neuromorphen Hardware verspricht: Erstmals wird ein Chip für die Beschleunigung von Spiking Neural Networks (SNN) in Verbindung mit dem sogenannten verteilten Lernen (Federated Learning) entwickelt. Am Fraunhofer IAIS liegt dabei der Fokus auf der Entwicklung von SNNs für die Bilderkennung und die Detektion von Objekten. Wichtig für uns ist dabei, besonders energieeffiziente und auf kleiner Hardware einsetzbare Modelle zu erschaffen.

»SEC-Learn« – Sensor Edge Cloud für verteiltes Lernen

Spiking Neural Networks in der intelligenten Bilderkennung

Das Projekt SEC-Learn beschäftigt sich mit Verarbeitung am äußersten Rand der Recheneinheiten: Den Sensoren, die jedem Rechensystem Input liefern müssen (Sensor Edge). Die sensornahe Verarbeitung spart nicht nur die Datenübertragung und damit Energie, sondern schützt dadurch auch die Daten und damit die Privatsphäre aufgenommener Personen vor Diebstahl und Manipulation.

Die Verarbeitung soll dabei durch sogenannte Spiking Neural Neural Networks geschehen; diese stellen eine Herausforderung für komplexere KI-Modelle dar, versprechen aber enormes Potential (s. u.). Hinzu kommt, dass jedes Edge-Gerät durch verteiltes Lernen lokal Informationen zum »Trainieren« nutzen soll und diese über ein Cloud-System an andere Edge-Geräte verteilt. Statt potenziell sensibler Daten wird dabei nur das abstrakte gelernte Wissen übertragen.

Was sind Spiking Neural Networks?

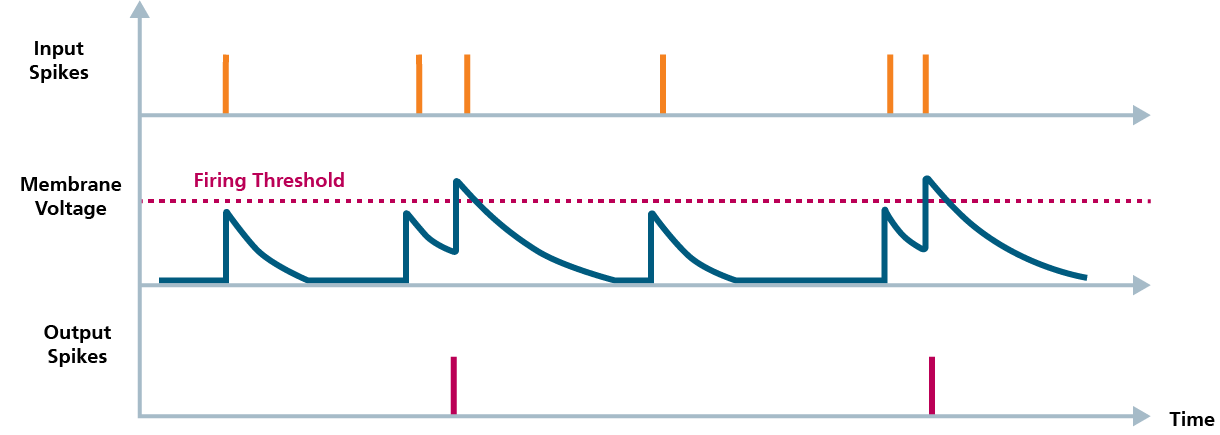

Spiking Neural Networks (SNNs) zeichnen sich durch einen weiteren Schritt in Richtung biologische Neuronen aus: Statt innerhalb des Netzwerks arbiträre Werte aus einem großen Zahlenbereich zu nutzen, werden die Signale zwischen den Neuronenschichten auf Nullen und Einsen reduziert – letztere werden »Spikes« genannt. Dies entspricht dem biologischen Neuron und kann in elektronischen Schaltkreisen durch ein einziges Bit Information (statt wie sonst üblich 8, 16 oder 32) übermittelt werden.

Der Vorteil: Hohe Energieeinsparungen

Neuromorphe Hardware, die auf SNNs ausgelegt ist, verspricht eine ungeheure Energieeinsparung, da in diesen tatsächlich nur bei Spikes Energie fließt. Anders also als bei den allermeisten regulären Neuronalen Netzwerken, in denen bei jedem Input von jedem Neuron ein Signal an die nächste Schicht im Netzwerk übermittelt werden muss, beschränken sich diese in einem SNN auf die wenigen aktiven Neuronen in jeder Schicht.

Wer kann davon profitieren?

Jede Anwendung von verteilten Sensorsystemen kann potenziell von SEC-Learn profitieren. Dies kann z. B. der Einsatz im Fabrikumfeld bei Sensoren zur Produktionsüberwachung sein, wo ggf. viele Daten anfallen, deren sensornahe Verarbeitung viel Energie spart. Zum Anderen bieten sich aber auch Anwendungen im öffentlichen oder privaten Raum an, wo oftmals besonders sensible Daten anfallen und die Datenschutzanforderungen sehr hoch ist.

Bilderkennung mit Spiking Neural Networks – an der Spitze der Forschung

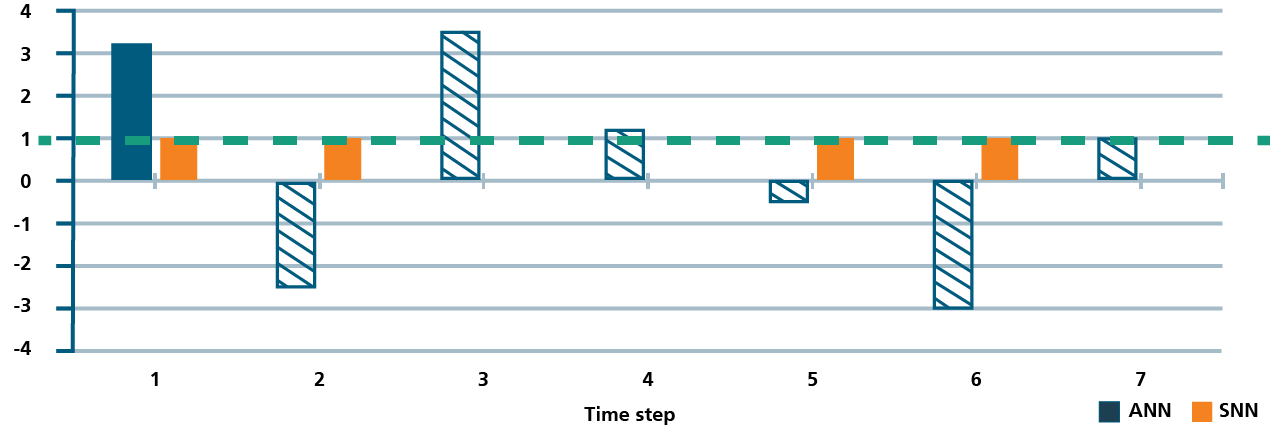

Die Einschränkung auf binäre Neuronensignale bedeutet natürlich eine massive Einschränkung der Ausdrucksfähigkeit des Modells. Daher ist die Lösung von komplexen Problemen wie Objektdetektion in der Computer Vision mit SNNs alles andere als trivial. Erfolgreiche Ansätze zur Lösung dieses Problems sind noch sehr rar, daher forscht das Fraunhofer IAIS hier an vorderster Front. Besonderer Fokus liegt bei uns auf der Entwicklung besonders kleiner SNNs, denn die Dimension sowohl der wenigen existierenden SNN-Chips als auch der im Projekt entwickelten sind begrenzt und erlauben nicht die sonst üblichen größeren Netzwerke.